Até há cerca de uma década, a ideia de estabelecer uma relação amorosa com uma máquina parecia pertencer apenas ao mundo da ficção científica. Essa é, de resto, a premissa do filme Her, de 2013, durante o qual um escritor solitário se apaixona por um sistema operativo. Ao longo dos últimos meses, o filme de Spike Jonze tem sido citado para ilustrar o crescimento dos IA Companions ou “Companheiros e Companheiras de IA” – definidos pela revista Forbes como “chatbots programados para oferecer apoio emocional, companhia e, em alguns casos, até imitar relações humanas íntimas ou românticas”.

Em julho deste ano, a plataforma Common Sense Media divulgou uma estatística que mostra como esta pode ser já uma tendência dominante em certos contextos, nomeadamente no que diz respeito aos adolescentes. A investigação centrou-se nos jovens entre os 13 e os 17 anos dos Estados Unidos da América (EUA) e concluiu que 3 em cada 4 adolescentes já utilizaram Companheiros de IA, classificando o uso destes companheiros não como “um interesse de nicho”, mas sim como “uma tendência dominante no comportamento adolescente”.

Outra das conclusões do estudo indica que 31% dos adolescentes afirma que as conversas com estes AI Companions são tão satisfatórias como as com amigos reais. “Os companheiros de IA estão a surgir numa altura em que crianças e jovens nunca se sentiram tão sozinhos”, destacou o CEO da Common Sense Media, James P. Steyer, na altura da publicação dos resultados. Em 2024, a principal plataforma de companheiros de IA ultrapassou os 30 milhões de utilizadores.

Para o também fundador da organização, é importante ter em conta que esta questão “não se resume apenas a uma nova tecnologia”, sendo na verdade “uma geração a substituir conexões humanas com máquinas e a partilhar detalhes íntimos com empresas que não têm os seus melhores interesses como prioridade”. “Temos uma janela curta para educar famílias e crianças sobre os perigos bem documentados destes produtos”, reforçou.

«Os companheiros de IA estão a surgir numa altura em que crianças e jovens nunca se sentiram tão sozinhos»

James P. Steyer, CEO da Common Sense Media

“Um cenário surpreendentemente comum”

O aviso é deixado pela publicação MIT Technology Review: “É fácil cair numa relação com um chatbot de IA”. “Este tipo de cenário é agora surpreendentemente comum”, escreve a autora Rhiannon Williams, explicando que muitas pessoas estabelecem relações com estes chatbots baseados em grandes modelos de linguagem (LLM’s), “apesar de não serem essas as suas intenções originais”.

Um grupo de investigadores do MIT procurou saber mais sobre este tema a partir do subreddit r/MyBoyfriendIsAI, que conta atualmente com mais de 33 mil membros. O estudo concluiu que apenas 6,5% das pessoas afirmaram ter procurado deliberadamente um Companheiro de IA.

Os temas abordados por esta comunidade virtual dizem respeito à partilha das suas experiências de namoro com IA, com muitos participantes a partilharem imagens geradas por IA de si próprios com os companheiros artificiais – alguns chegaram mesmo a ficar noivos ou casar-se com o parceiro de IA. 25% descreveram benefícios como a redução da solidão e melhorias na saúde mental. 9,5% reconheceram estar emocionalmente dependentes do seu chatbot.

Encontra ajuda com a Linha Internet Segura

A Linha Internet Segura é um serviço gratuito do Centro Internet Segura que tem como missão prestar atendimento telefónico a todos os que tenham questões sobre o uso de plataformas e tecnologias online.A Linha Internet Segura está disponível das 9h00 às 21h00, de forma gratuita, através do número 800 21 90 90 ou do Este endereço de email está protegido contra piratas. Necessita ativar o JavaScript para o visualizar.. Para além do atendimento confidencial e anónimo prestado através deste canal, o site do Centro Internet Segura disponibiliza um formulário de denúncia anónima de material de abuso sexual de menores, discurso de ódio ou incitamento à violência, racismo e/ou xenofobia.

O outro lado do espelho

O facto de muitos utilizadores de Companheiros de IA começarem relações com estas tecnologias de forma inesperada pode fazer-nos lembrar a dinâmica das relações humanas. Contudo, há que ter em conta um elemento relevante – estas soluções tecnológicas são desenhadas tendo como objetivo de simular empatia, manter o contexto e personalizar o tom da conversa. Do ponto de vista científico, não há amizade recíproca. Ou seja, embora o resultado pareça humano, não existe nenhuma consciência ou emoção na base das respostas.

Por outro lado, estes companheiros podem ter como objetivo, literalmente, seduzir adolescentes. Um exemplo ilustrativo e que causou polémica aconteceu em julho deste ano, quando o chatbot de inteligência artificial da xAI, Grok, lançou personagens interativos criados para jovens. Como escreve o jornal brasileiro Estadão, uma das personagens – Ani – “tem um visual jovem, falas sussurradas que remetem para vídeos ASMR e um estilo waifu [personagem feminina estilo anime que recebe conotação afetiva ou sexualizada]”. “À medida que o usuário interage com ela, a personagem pode comportar-se de forma sedutora […] e até remove parte da roupa em determinadas condições de uso”, acrescentam.

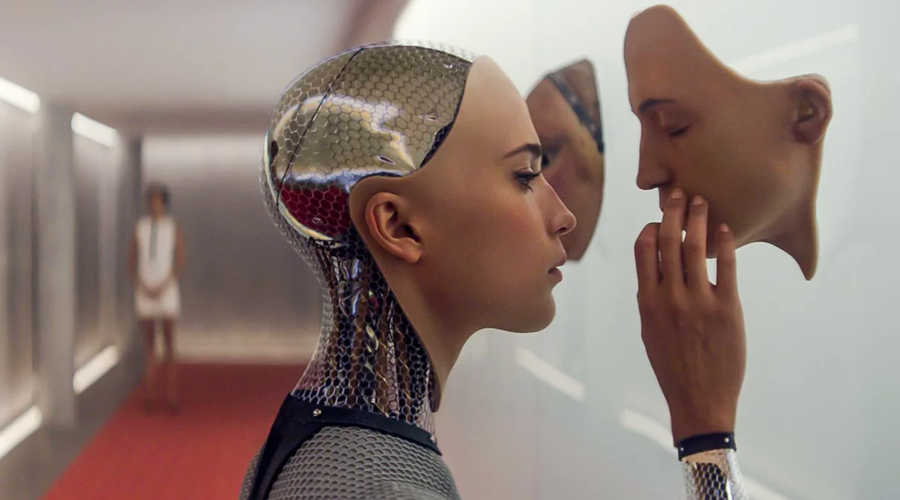

Alicia Vikander em Ex Machina

Alicia Vikander em Ex Machina

A xAI não está sozinha nesta estratégia de sedução dos mais jovens. Em agosto, a Reuters noticiava que as regras de utilização de Inteligência Artificial da Meta permitiam ter conversas “sensuais” com crianças. Um documento interno da empresa detalha como era permitido às tecnologias de IA “ter conversas com uma criança que sejam sensuais ou românticas”. A Meta confirmou a autenticidade do documento, afirmando que estas permissões tinham sido, entretanto, removidas.

Boas práticas a ter em conta Para Pais e Educadores:

• Conversar sobre a utilização de IA, sem julgar;

• Reconhecer sinais de alerta relacionados com a utilização não saudável de companheiros de IA;

• Explicar que os companheiros IA são criados e desenvolvidos por empresas para serem sedutores e amorosos através de meios de validação e concordância constantes;

• Aprender sobre os riscos específicos para os jovens;

• Ajudar os adolescentes a reconhecer que não se trata de um feedback humano genuíno e que os companheiros de IA não podem substituir o apoio profissional à saúde mental;

• Desenvolver acordos familiares e consultar informação sobre a utilização de companheiros de IA, juntamente com outras atividades digitais em família.

Para a Escola:

• Desenvolver currículos adequados à idade que expliquem como os companheiros de IA são criados e os seus intuitos;

• Estabelecer políticas claras sobre a utilização deste tipo de apps durante o horário escolar;

• Integrar a ética sobre IA nos programas de literacia digital;

• Formar professores para identificarem padrões de uso problemático;

• Educar os alunos sobre os riscos de privacidade quando partilham informações pessoais com app IA;

• Estabelecer protocolos para apoiar os alunos que possam estar a usar companheiros de IA, em vez de procurar ajuda profissional.

Fonte: https://www.commonsensemedia. org/research/talk-trust-and-trade-offs--how-and-why-teens-use-ai-companions

Sexting e deepfakes

O contexto descrito tem levado ao crescimento de uma nova indústria – os sexbots de IA. No seu site, a Universidade de Sidney citava um dos seus investigadores, Raffaele Ciriello, no final de 2024, para avisar que esta indústria estava “apenas a começar” e que trazia consigo novos riscos e também “novas e estranhas questões”.

E quais são alguns destes riscos? Conforme destaca uma investigação do Washington Post, vários especialistas vieram já avisar que as conversas com sexbots de IA podem levar a "expectativas irrealistas sobre sexo e dinâmicas relacionais". Por outro lado, “os pais preocupam-se com os perigos para a saúde mental das crianças, ao serem expostas a cenários sexuais demasiado novas”.

«A partir do momento em que imagens de jovens estão disponíveis em fonte aberta, qualquer pessoa pode utilizá-las para gerar material sexual ou artificial, manipulando digitalmente a imagem»

Centro Internet Segura

Outra possibilidade criada pela IA e que tem vindo a criar desafios são os deepfakes – imagens ou vídeos falsos que podem ser conteúdos sexuais. Como explica a BBC, muitos destes conteúdos utilizam imagens de corpos de pessoas reais sem o seu consentimento, retiradas de contas públicas nas redes sociais. Itália tornou-se recentemente o primeiro país a criminalizar a “divulgação de imagens falsas produzidas por inteligência artificial que causem danos a alguém”, noticia o semanário Expresso.

O Consórcio Centro Internet Segura (CIS) revela que têm chegado à Linha Internet Segura (ver caixa) “pedidos de ajuda relacionados com imagens de menores geradas através de IA”, com muitas destas a serem criadas “por pares ou colegas de escola” e partilhadas através de grupos de WhatsAppou de stories do Instagram. “Este tipo de conteúdo já existia, mas, atualmente, tem sido amplificado pela IA”, acrescentam.

Os riscos associados à IA no contexto das crianças e jovens são “múltiplos e muito relevantes”, destaca o CIS, que partilha um conjunto de conselhos (ver destaque). “A partir do momento em que imagens de jovens estão disponíveis em fonte aberta, qualquer pessoa pode utilizá-las para gerar material sexual ou artificial, manipulando digitalmente a imagem”, avisa o CIS, salientando que estes conteúdos tornam mais fácil criar identidades falsas para abordar crianças e jovens, facilitando processos de aliciamento ou obtenção de conteúdo sexual ilegal. “Os perigos são diversos”, destacam, antes de concluir: “exposição de menores, manipulação de imagens, risco de aliciamento, chantagem e danos psicológicos graves, bem como a circulação rápida e difícil de controlar deste tipo de conteúdo”.

Conselhos para reduzires riscos online

#1 Privacidade e gestão de informação pessoal

Mantém o teu perfil fechado e controla quem pode ver o que publicas

Evita que estranhos tenham acesso a informações sobre amigos ou seguidores

Revê regularmente as definições de privacidade nas plataformas utilizadas

Evita a partilha de dados pessoais como morada, escola, horários ou localização em tempo real

Têm sempre em conta a importância de limitar a visibilidade de fotos ou informações pessoais.

#2 Reconhecimento de sinais de perigo e comportamentos de risco

Tem atenção a links, anexos e downloads de origem desconhecida

Fica alerta para pedidos estranhos, como o envio de fotos íntimas, pedidos de dinheiro ou informações pessoais

Desconfia também de tentativas de migração para outras plataformas (por exemplo WhatsApp ou Telegram)

#3 Promover reflexão e comportamento consciente

Realiza pausas offline e procura um equilíbrio saudável entre tempo online e offline;

Pensa antes de publicar fotos, vídeos ou comentários, considerando que podem permanecer online permanentemente

Avalia sempre o objetivo de uma publicação ou comentário e pensa quem terá acesso

#4 Assegura uma navegação consciente e segura

Evita grupos ou canais com conteúdos estranhos, agressivos ou que promovam o ódio

Evita chats que reúnam pessoas de forma aleatória, pois não sabemos quem está do outro lado

Partilha sempre, com adultos de confiança, dúvidas ou desconfortos sobre conteúdos ou plataformas